Pentesting d'IA avec ATLAS Matrix

Comprendre les tactiques et techniques adversariales sur les systèmes d’intelligence artificielle pour anticiper les menaces et évaluer la surface d’exposition

L’intégration croissante de l’intelligence artificielle dans les systèmes critiques, les services numériques et les chaînes d’approvisionnement élargit considérablement la surface d’attaque.

Les menaces ne se limitent plus aux vecteurs classiques : elles visent directement les modèles, les données d’entraînement et les API d’inférence.

Des incidents réels montrent l’ampleur du risque. L’un d’eux, documenté par MITRE, a entraîné plus de 77 millions de dollars de pertes après une attaque adversariale contre un système de reconnaissance faciale utilisé par une administration fiscale étrangère.

Pour répondre à ce type de menace, MITRE a créé ATLAS (Adversarial Threat Landscape for AI Systems), une base de connaissances vivante des tactiques et techniques adversariales, construite à partir d’observations réelles et de démonstrations par des red teams IA (ou pentesting d’IA).

ATLAS et ATT&CK : un lien direct

ATLAS s’inspire directement du cadre MITRE ATT&CK®, largement utilisé en cybersécurité pour cartographier les tactiques, techniques et procédures (TTPs) des attaquants.

Complémentarité : ATLAS couvre les menaces spécifiques aux systèmes IA, en parallèle des attaques classiques décrites dans ATT&CK.

Adaptations : les tactiques signalées par un

&sont des adaptations directes du framework ATT&CK, adaptées au contexte IA.Finalité : permettre aux analystes de sécurité et pentesters IA de relier menaces traditionnelles et adversariales pour une vision globale.

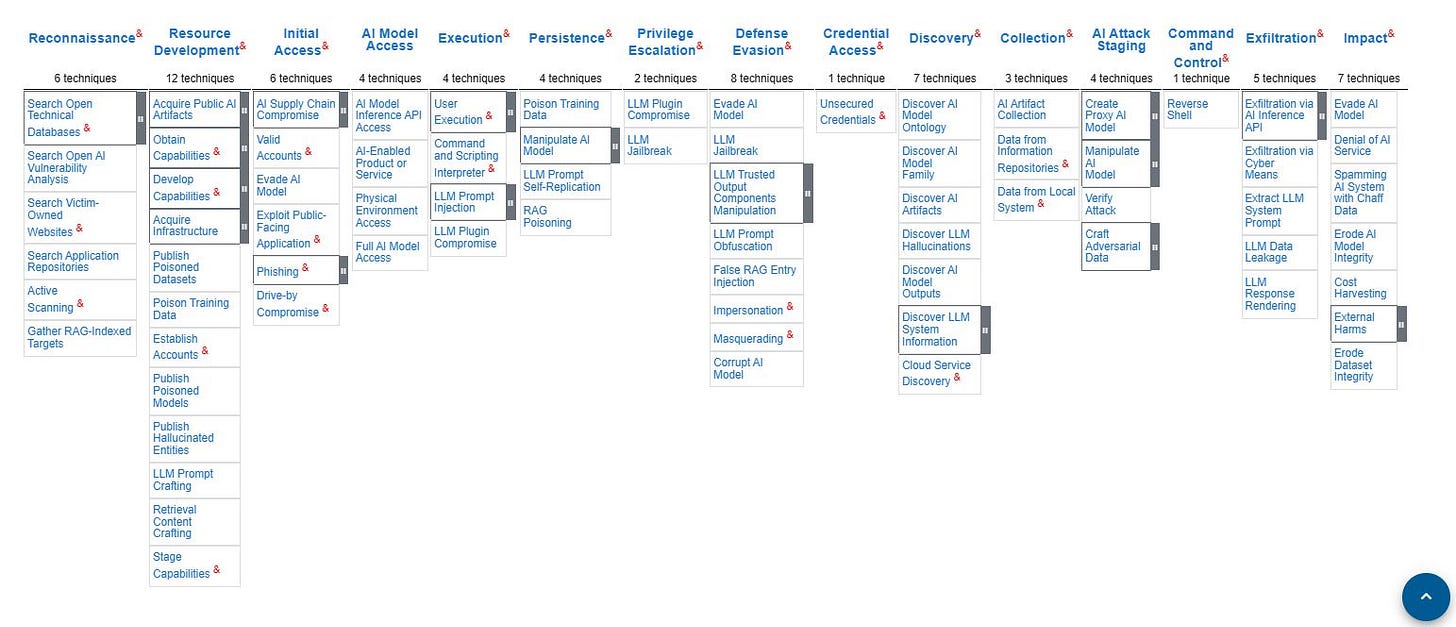

Les 15 tactiques de la matrice ATLAS

La matrice ATLAS décrit la progression d’une attaque IA en 15 tactiques. Chaque tactique regroupe un ensemble de techniques précises.

Le symbole (&) n’est pas une erreur : il indique qu’une tactique ATLAS est adaptée directement du framework MITRE ATT&CK.

Reconnaissance (&) (6 techniques) : collecte d’informations sur la cible, ses modèles et ses données (exemple : recherche dans des bases techniques publiques).

Développement de ressources (&) (12 techniques) : préparation des outils et artefacts pour l’attaque (empoisonnement de datasets, création de modèles ou contenus malveillants).

Accès initial (&) (6 techniques) : obtention d’un point d’entrée dans l’environnement cible (phishing, exploitation d’API d’inférence, compromission d’applications).

Accès au modèle IA (4 techniques) : accès direct au modèle (exemple : exploitation d’une API, accès physique à l’environnement IA).

Exécution (&) (4 techniques) : déclenchement d’actions malveillantes (injection de prompts, compromission de plugins LLM).

Persistance (&) (4 techniques) : maintien de l’accès dans le temps (empoisonnement de données d’entraînement, auto-réplication de prompts).

Escalade de privilèges (&) (2 techniques) : élévation des permissions pour élargir le contrôle.

Évasion des défenses (&) (8 techniques) : contournement des protections et dissimulation (jailbreak LLM, obfuscation de prompts, manipulation de composants de sortie).

Accès aux identifiants (&) (1 technique) : vol ou abus d’identifiants et de clés d’accès.

Découverte (&) (7 techniques) : exploration de l’environnement IA (découverte d’artefacts, analyse des hallucinations d’un LLM, récupération d’informations système).

Collecte (&) (3 techniques) : extraction de données et d’artefacts IA (collecte locale, via services cloud ou dépôts d’information).

Mise en scène de l’attaque IA (4 techniques) : préparation et validation d’attaques adversariales (création de données malveillantes, manipulation de modèles intermédiaires).

Commande et contrôle (&) (1 technique) : communication avec des systèmes compromis, utilisation d’IA comme relais.

Exfiltration (&) (5 techniques) : vol et extraction de données ou de modèles (via API d’inférence, fuite de prompts système).

Impact (&) (7 techniques) : atteinte aux objectifs finaux de l’attaquant (déni de service IA, corruption de modèles, augmentation des coûts d’inférence, érosion de l’intégrité des datasets).

Cette structuration permet de visualiser la progression d’une attaque de bout en bout, depuis la collecte initiale d’informations jusqu’à l’impact sur le modèle et l’organisation.

L'ensemble de ce framework ne se limite pas à la description des attaques. Il est organisé en trois piliers interconnectés pour offrir une vision complète de la menace et de la défense :

Tactiques : Les objectifs tactiques de l'adversaire (le "pourquoi"). Pour en savoir plus, consultez les Tactiques ATLAS.

Techniques : Les méthodes spécifiques utilisées pour atteindre ces objectifs (le "comment"). Pour explorer les détails, consultez les

Mesures d'atténuation : Les concepts et technologies de sécurité qui peuvent être utilisés pour prévenir ou contrer les attaques. Pour voir les solutions, consultez les

Au-delà de la matrice : un écosystème d'outils et de collaboration

Le framework ATLAS est bien plus qu'une simple matrice théorique. Il s'appuie sur un écosystème complet d'outils et sur une communauté active pour passer de la connaissance à l'action.

Une boîte à outils pour la simulation et la connaissance

Pour rendre la matrice exploitable, MITRE et ses collaborateurs ont développé des outils concrets :

ATLAS Navigator offre une interface interactive pour explorer les tactiques et techniques, et visualiser leurs liens avec le framework ATT&CK Enterprise.

Arsenal et Almanac sont des plugins pour l'outil de simulation de menaces CALDERA™. Développés en 2023, ils permettent aux équipes de Red Team de simuler activement des attaques adverses contre des systèmes d'IA.

La base de données des risques IA (AI Risk Database) est une ressource open-source qui documente les vulnérabilités découvertes sur des modèles d'IA publics, enrichie par les contributions de la communauté.

Une ressource stratégique pour les équipes de sécurité

L'objectif principal d'ATLAS est de fournir un référentiel structuré pour renforcer la sécurité de l'IA. Il est conçu pour aider les analystes et les développeurs à comprendre les menaces réalistes et les comportements adverses observés sur le terrain.

Pour les équipes de pentesting (AI Red Team), il s'agit d'un guide pratique pour :

Soutenir les évaluations de risques et les missions de red teaming interne.

Identifier les vulnérabilités spécifiques aux modèles d'IA et à leurs données.

Évaluer la surface d'exposition et prioriser les scénarios de test.

Le moteur collaboratif

Cette richesse d'informations provient d'une communauté collaborative animée par MITRE, qui réunit des experts de l'industrie, du monde universitaire et des gouvernements. Les contributions de cette communauté sont essentielles et prennent plusieurs formes :

Le signalement d'incidents réels visant des systèmes d'IA, partagés de manière sécurisée ou anonymisée pour enrichir la base de connaissances.

La participation à des groupes de travail internationaux, comme l'initiative de l'OTAN lancée en 2023 pour adresser les menaces sur les systèmes IA.

Conclusion

Plus qu'une simple cartographie des menaces, MITRE ATLAS est un écosystème vivant qui combine une base de connaissances exhaustive, des outils de simulation pratiques et une communauté mondiale d'experts.

En reliant les menaces cyber traditionnelles à celles, spécifiques, qui ciblent l'intelligence artificielle, il s'impose comme une ressource de référence indispensable pour les analystes, les chercheurs et les pentesters qui cherchent à comprendre, anticiper et neutraliser les attaques de nouvelle génération.